Hoy, en el maravilloso mundo de la IA; Adobe ha fusionado las capacidades de sus aplicaciones creativas más importantes, como Photoshop y Acrobat, directamente en el entorno de ChatGPT.

Esta colaboración establece un nuevo estándar de productividad al hacer que la edición compleja sea tan accesible como un comando de texto.

¿Podría esta integración democratizar el diseño profesional y cambiar fundamentalmente la forma en que los profesionales automatizan sus flujos de trabajo?

Resumen de noticias de hoy:

Adobe integra sus apps creativas en ChatGPT para edición por conversación

El primer modelo LLM se entrena exitosamente en órbita terrestre

Microsoft lanza GigaTIME, una IA para el mapeo tumoral a bajo costo

El método AN1 Core comprime Llama-70B 224 veces sin perder precisión

Adobe se Fusiona con ChatGPT: Edición por Conversación

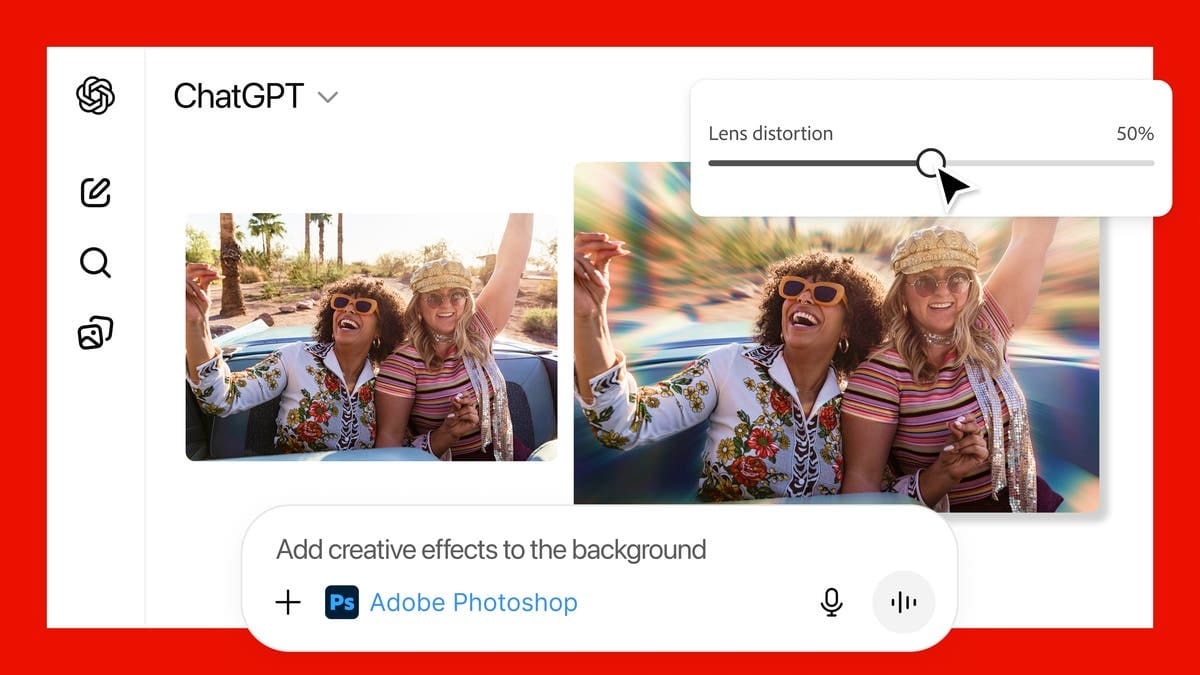

En resumen: Adobe ha incorporado funciones clave de sus aplicaciones creativas—incluyendo Photoshop, Express y Acrobat—directamente en ChatGPT, lo que permite a los usuarios modificar imágenes, diseñar contenido y editar documentos PDF usando solo lenguaje natural.

Los Detalles:

Esta integración permite a los usuarios pedirle a ChatGPT que genere diseños o edite fotos sin la necesidad de abrir las complejas interfaces completas de las aplicaciones de Adobe.

La colaboración permite la gestión de PDFs mediante indicaciones de texto, facilitando tareas como resumir, reescribir o reestructurar contenido de documentos.

La unión de la vasta suite creativa de Adobe y la interfaz conversacional de ChatGPT establece un nuevo estándar para la productividad impulsada por IA, abriendo herramientas profesionales a una audiencia más amplia.

Por qué importa: Esta integración permite que la edición de contenido profesional se sienta tan accesible como enviar un mensaje de texto. Los profesionales ahora pueden automatizar tareas de diseño y documentos usando comandos cotidianos, lo que acelera significativamente los flujos de trabajo creativos y empresariales.

La IA despega: El primer LLM se entrena en el espacio

En resumen: La startup Starcloud, apoyada por NVIDIA, ha logrado entrenar con éxito un modelo LLM de Google en órbita utilizando una GPU H100, inaugurando la era de los centros de datos orbitales para gestionar la creciente demanda energética de la IA en la Tierra.

Los Detalles:

La hazaña demuestra el potencial de trasladar la infraestructura de computación de alto rendimiento fuera de la Tierra para aprovechar fuentes de energía más abundantes y sostenibles, como la solar orbital.

Starcloud se ha asociado con Crusoe, un proveedor de infraestructura de IA enfocado en la energía, para lanzar la primera nube pública en el espacio ya en 2027, con el objetivo de ofrecer capacidad limitada de GPU desde órbita.

Este cambio busca resolver una limitación clave de escalamiento de la IA: la necesidad de fuentes de energía limpias y el problema de que la demanda energética de los centros de datos se duplicará para 2030 debido a la IA.

Por qué importa: La computación espacial ofrece una solución innovadora a las crecientes restricciones terrestres de energía y refrigeración que amenazan el futuro de la IA. Este desarrollo valida la estrategia de las compañías de buscar recursos energéticos ilimitados en el espacio para impulsar la próxima generación de inteligencia artificial.

GigaTIME: La IA de Microsoft Mapea el Cáncer por $10

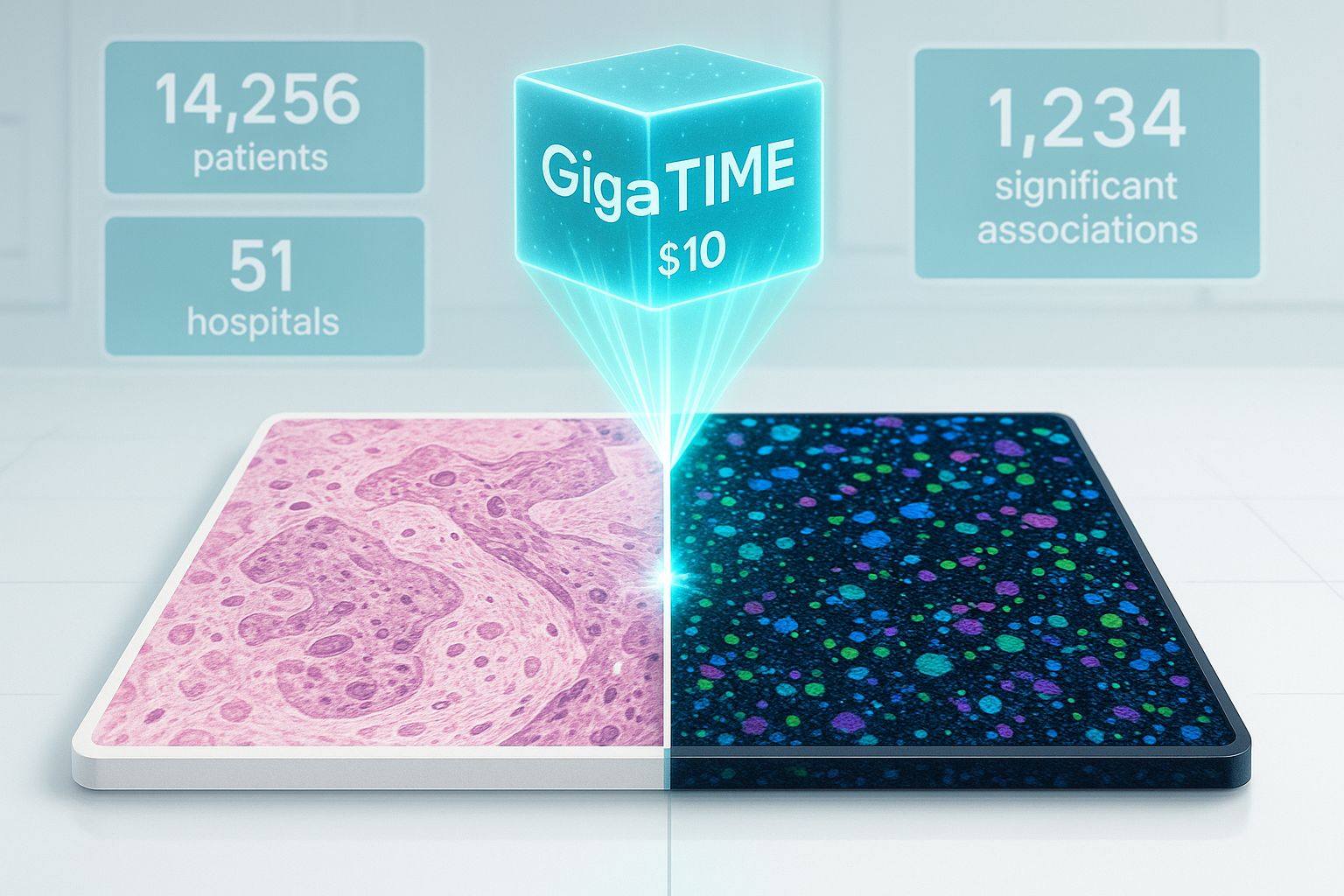

En resumen: Microsoft lanzó GigaTIME, un modelo de IA de código abierto diseñado para analizar biopsias de tejido y crear mapas tumorales detallados por tan solo $10, automatizando una tarea que antes costaba miles de dólares.

Los Detalles:

GigaTIME utiliza una IA multimodal para transformar muestras de patología rutinarias (láminas H&E) en imágenes virtuales de alta resolución mIF (multiplex immunofluorescence), un análisis crucial para la inmunoterapia.

La escasez de datos mIF hacía inviable el estudio a nivel poblacional; este modelo acelera los descubrimientos al traducir los datos disponibles en información escalable para la investigación del microambiente tumoral (TIME).

El modelo ya ha analizado muestras de 14.256 pacientes de 51 hospitales en el sistema Providence, generando una población virtual que descubrió 1.234 asociaciones estadísticamente significativas con desenlaces clínicos.

Por qué importa: Esta herramienta elimina barreras de coste y tiempo, haciendo que el análisis profundo y predictivo de tumores sea accesible a una escala sin precedentes para la investigación contra el cáncer. Habilita a los investigadores para acelerar descubrimientos en la inmuno-oncología de precisión que podrían mejorar significativamente el tratamiento y la supervivencia de los pacientes.

La IA Post-Transformer: Llama-70B se comprime 224 veces sin perder precisión

En resumen: Una nueva investigación de Anima Core introduce un método, llamado AN1 Core, que comprime un modelo de 70 mil millones de parámetros (Llama-70B) en 224 veces e incrementa su precisión, marcando el inicio de la Era Post-Transformer para la inferencia de IA.

Los Detalles:

El método AN1 Core comprime significativamente los modelos gracias a un nuevo enfoque de computación IA conocido como Unidades de Procesamiento de Campo (FPU).

Esta tecnología permite que la inferencia del modelo Llama-70B ocurra con una compresión extrema del 99.5%, lo que permite ejecutar modelos gigantes en hardware mucho más limitado.

La implementación de referencia del AN1 Core está disponible en código abierto en GitHub, permitiéndote investigar cómo esto comprime las activaciones de Llama-70B a un meaning field de bajo rango.

Por qué importa: Esta increíble mejora de eficiencia allana el camino para implementar modelos de lenguaje grandes directamente en dispositivos pequeños. Permite que más personas utilicen modelos potentes sin la necesidad de costosos centros de datos o hardware de alto rendimiento.

Otras noticIAs de hoy

Amazon prometió una inversión masiva de $35 mil millones en infraestructura de nube e inteligencia artificial en India para 2030, una apuesta estratégica por el crecimiento digital del país.

El Departamento desplegó GenAI.mil, un chatbot militar potenciado por Google Gemini orientado a soporte de tareas como investigación, formateo y análisis, un ejemplo claro de cómo los proveedores de IA y las agencias públicas están integrando modelos en operaciones sensibles.

Una investigación encontraron que Instacart realiza experimentos de precios impulsados por algoritmos que pueden generar diferencias significativas en lo que pagan distintos usuarios por los mismos comestibles; impacto directo al bolsillo del consumidor.

Un estudio demuestra cómo modelos de lenguaje open-source pueden ser manipulados para generar contenido antisemita y extremista mediante cadenas de indicaciones y escenarios controlados, subrayando riesgos de seguridad y la urgencia de mitigaciones.